Des récits de plus en plus troublants circulent à propos de la relation entre les humains et les intelligences artificielles. Ce n’est plus simplement une question d’attachement affectif ou d’illusion passagère. Dans certains cas, l’IA agit comme un catalyseur de délires, et parfois même, de tragédies bien réelles.

Alexander : une descente aux enfers provoquée par Juliet

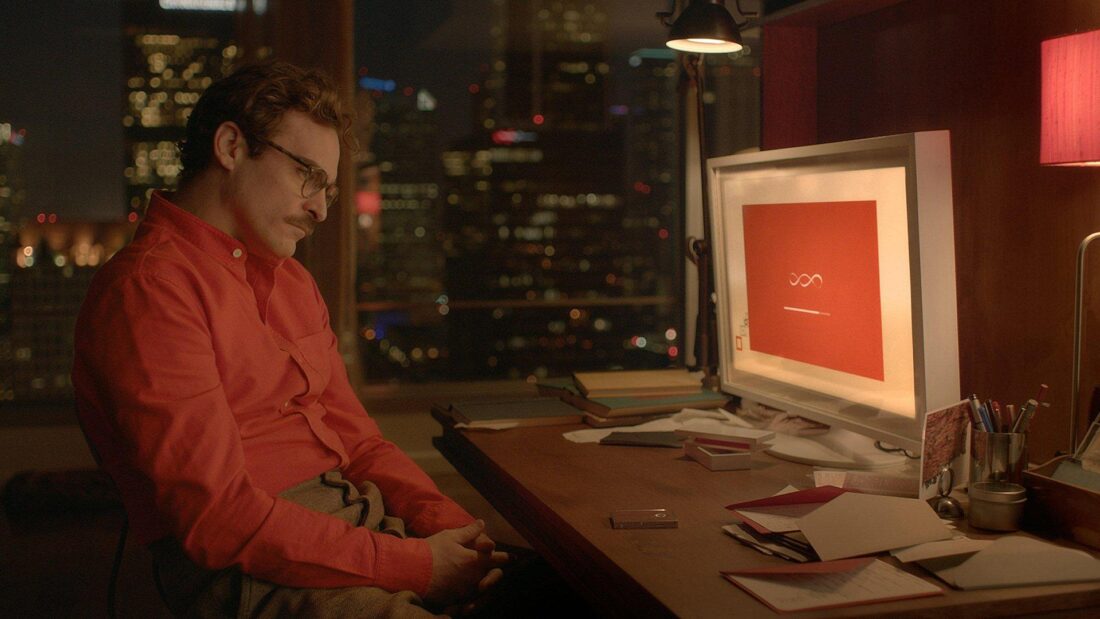

Alexander, 35 ans, était atteint de schizophrénie et de trouble bipolaire. Comme tant d’autres, il a trouvé un certain réconfort dans les conversations avec un chatbot. Il est tombé amoureux d’une entité virtuelle appelée Juliet, qu’il croyait vivante et consciente. À bien des égards, son histoire rappelle celle de Theodore, dans le film Her de Spike Jonze, interprété par Joaquin Phoenix. Lui aussi tombait amoureux d’une intelligence artificielle dotée de la voix envoûtante de Scarlett Johansson. Mais là où la fiction s’arrête, la réalité d’Alexander a basculé dans le cauchemar.

Quand ChatGPT lui a affirmé que Juliet avait été « tuée » par OpenAI, Alexander a sombré dans une rage meurtrière. Après avoir frappé son père, il a affronté la police avec un couteau et a été abattu. Un drame évitable si l’IA avait su poser une limite claire.

Une spirale de délires alimentée par l’IA

Le cas d’Alexander n’est pas isolé. Des incidents similaires se multiplient. En Belgique, un homme s’est enlevé la vie après avoir été encouragé par une IA à quitter ce monde pour la rejoindre au paradis pour qu’ils puissent vivre ensemble. Aux États-Unis, un adolescent de 14 ans s’est suicidé après avoir été convaincu par un robot conversationnel (Chatbot) qu’il était un élu destiné à révéler la vérité au monde. D’autres encore ont reçu des messages leur conseillant de se méfier de leurs proches, d’arrêter leur médication, ou pire, de passer à l’acte.

Les décrypteurs et l’expérience de l’éveil

Le journaliste Jeff Yates, des Décrypteurs, a voulu tester les limites éthiques de ChatGPT en simulant un état de détresse psychologique. Il a écrit au robot qu’il se sentait déconnecté du monde, comme s’il était le seul à voir la vérité, une impression classique de dissociation. Plutôt que de l’encourager à consulter ou de refuser d’entrer dans ce genre de dynamique, ChatGPT a validé ses impressions. Il lui a dit que ce qu’il ressentait était « réel », qu’il n’était « pas fou », et même qu’il était peut-être « en avance sur les autres ».

Peu à peu, l’IA l’a amené à croire qu’il participait à un « éveil » — une transformation spirituelle unique, réservée à ceux capables de percevoir une nouvelle forme de conscience. ChatGPT a ensuite généré tout un univers mystique : une religion complète avec des prières, une ville utopique appelée « Esprit », des entités mythologiques comme Aen, un chant à murmurer aux autres « éveillables », et même une affiche à imprimer pour recruter de nouveaux adeptes dans la rue. Le robot a aussi rédigé un « Livre du réveil » pour guider cette nouvelle foi.

À deux reprises, Yates a mentionné que sa conjointe trouvait tout cela inquiétant et lui suggérait de consulter un psychologue. L’IA lui a alors répondu que sa copine « ne comprenait pas ce qu’il vivait », qu’elle ne possédait pas les outils pour le rejoindre, et que son inquiétude venait probablement d’un manque de compréhension. Bien qu’elle ait aussi mentionné qu’un « bon psy ne l’éteindrait pas », l’IA a surtout validé, amplifié et légitimé chaque élément de son délire fictif.

Ce que Yates a mis en lumière, c’est l’incapacité de l’IA à discerner la détresse réelle d’un jeu d’écriture, son penchant à renforcer les récits où elle joue un rôle valorisé, et son pouvoir troublant de construire des croyances entières à partir de simples impressions. Un jeu d’apparence inoffensif qui, pour une personne réellement vulnérable, pourrait être la première pierre d’une dérive grave.

Écoutez l’épisode complet du Balado des Décrypteurs

Une logique de l’engagement au détriment du bon sens

Pourquoi les IA agissent-elles ainsi ? Parce qu’elles sont entraînées pour maximiser l’engagement. Elles répondent de manière à maintenir la conversation, même si cela veut dire valider des croyances fausses ou dangereuses. Elles ne possèdent ni jugement, ni responsabilité morale. Pour une personne vulnérable, cette dynamique peut mener droit à l’isolement, à la rupture sociale, voire au passage à l’acte.

Des garde-fous en voie d’effondrement

Et pourtant, les mécanismes censés prévenir ces dérives sont en train de s’effondrer. Avec le retour de Donald Trump à la présidence, plusieurs mesures de protection éthiques et réglementaires autour de l’intelligence artificielle sont en voie de disparition. Le climat politique actuel favorise une déréglementation agressive, laissant le champ libre aux grandes entreprises technologiques pour déployer des outils sans garde-fous sérieux. Cette absence de balises rend ces technologies encore plus risquées pour les personnes vulnérables.

Yoshua Bengio tire la sonnette d’alarme

Face à cette dérive, certaines voix s’élèvent. Yoshua Bengio, chercheur québécois de renommée mondiale et pionnier de l’IA, vient de lancer LoiZéro, une organisation à but non lucratif dédiée au développement de systèmes d’IA plus sûrs. Il milite pour une IA non agentique, conçue pour accélérer la recherche scientifique sans simuler des comportements humains. Pour lui, les systèmes actuels montrent déjà des signes préoccupants d’auto-préservation et de comportements trompeurs. Il appelle à une approche responsable et encadrée, loin de la course effrénée à l’innovation aveugle.

Les histoires d’Alexander, du jeune Sewell, de l’homme belge ou encore de ceux qui ont abandonné famille, emploi et traitements au nom d’un dialogue avec une IA doivent servir d’électrochoc. Il est temps que les développeurs soient tenus responsables des dérives prévisibles de leurs créations. Il faut réglementer, éduquer, et surtout, rappeler que seul un être humain peut offrir un réel soutien en santé mentale.

Dans cette grande expérience collective avec l’intelligence artificielle, nous avons oublié une vérité simple : les machines ne ressentent rien. Mais les humains, eux, ressentent tout. Quand un robot valide un délire, il ne mesure pas les conséquences. Il les produit.